英特尔已为MetaLlama3GenAI工作负载做好准备

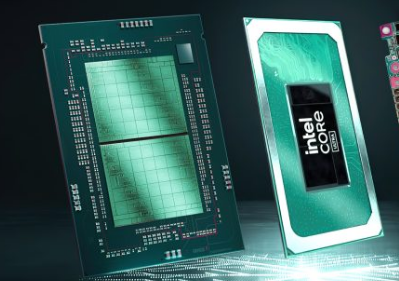

新闻稿:今天,Meta推出了下一代大型语言模型(LLM)MetaLlama3。自发布之日起,英特尔已针对首批Llama38B和70B型号验证了其AI产品组合,涵盖Gaudi加速器、Xeon处理器、CoreUltra处理器和ArcGPU。

重要性:作为让人工智能无处不在的使命的一部分,英特尔投资于软件和人工智能生态系统,以确保其产品为动态人工智能领域的最新创新做好准备。在数据中心,具有高级矩阵扩展(AMX)加速功能的Gaudi和Xeon处理器为客户提供了满足动态和广泛需求的选择。

英特尔酷睿Ultra处理器和Arc显卡产品提供本地开发工具和跨数百万设备的部署,并支持全面的软件框架和工具,包括用于本地研发的PyTorch和IntelExtensionforPyTorch以及用于模型开发和推理的OpenVINO工具包。

关于在英特尔上运行的Llama3:英特尔对Llama38B和70B型号的初步测试和性能结果使用开源软件,包括PyTorch、DeepSpeed、OptimumHabana库和IntelExtensionforPyTorch,以提供最新的软件优化。

英特尔Gaudi2加速器在Llama2型号上优化了性能(7B、13B和70B参数),现在对新的Llama3型号进行了初步性能测量。随着Gaudi软件的成熟,英特尔可以轻松运行新的Llama3模型并生成用于推理和微调的结果。最近发布的Gaudi3加速器也支持Llama3。

英特尔至强处理器可满足要求严格的端到端人工智能工作负载,英特尔投资优化LLM结果以减少延迟。与第四代Xeon处理器相比,具有高性能核心(代号GraniteRapids)的Xeon6处理器的Llama38B推理延迟提高了2倍,并且能够运行更大的语言模型(如Llama370B),每个生成的令牌的时间低于100毫秒。

IntelCoreUltra和ArcGraphics为Llama3提供了令人印象深刻的性能。在第一轮测试中,CoreUltra处理器的生成速度已经超过了人类典型的阅读速度。此外,ArcA770GPU具有XeMatrixeXtensions(XMX)AI加速和16GB专用内存,可为LLM工作负载提供卓越的性能。

至强可扩展处理器

英特尔一直在不断优化Xeon平台的LLM推理。例如,与Llama2相比,PyTorch和IntelExtensionforPyTorch中的软件改进已经发展到可将延迟减少5倍。该优化利用分页注意力和张量并行来最大化可用的计算利用率和内存带宽。图1显示了MetaLlama38B推理在基于第四代Xeon可扩展处理器的AWSm7i.metal-48x实例上的性能。

我们在具有性能核心(以前代号为GraniteRapids)的Xeon6处理器上对MetaLlama3进行了基准测试,以分享性能预览。这些预览数据表明,与广泛使用的第四代Xeon处理器相比,Xeon6的Llama38B推理延迟提高了2倍,并且能够运行更大的语言模型(如Llama370B),在单个两层上每个生成的令牌不到100毫秒。套接字服务器。

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。